F-mesure

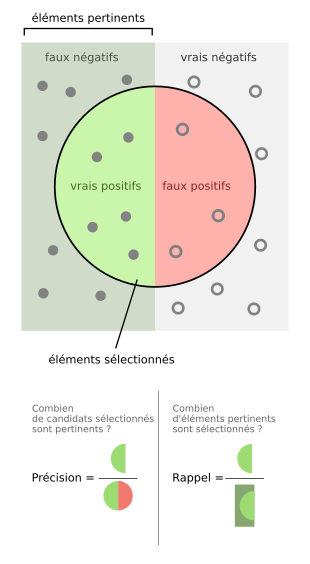

La F-mesure ou le F-score, souvent notée ou , est une mesure de la performance d'un modèle de classification en intelligence artificielle et statistique. Elle combine les mesures de précision et rappel, elles-mêmes basées sur les taux de vrais positifs, faux positifs et faux négatifs. L'idée de la F-mesure est de s'assurer qu'un classificateur fait de bonnes prédictions de la classe pertinente (bonne précision) en suffisamment grand nombre (bon rappel) sur un jeu de données cible. Tout comme la précision et le rappel, la F-mesure varie de 0 (plus mauvaise valeur) à 1 (meilleure valeur possible).

Définition

Classification binaire

Dans le cadre de la classification binaire, la F-mesure, notée ici

.

Avec, pour rappel :

Pour obtenir

.

En cas de division par zéro, on notera

Dans la définition de

Ainsi, on notera par exemple

Classification en classes multiples

Dans le cas où les prédictions du classificateur ne sont plus binaires (dit multi-classes), la F-mesure se calcule en faisant la moyenne des

- l'approche « micro » où les taux de VP, FP et FN de chaque classe sont simplement additionnés pour calculer le F-score ;

- l'approche « macro » où le F-score est la moyenne arithmétique des F-score de chaque classe.

Exemple

Dans le cadre de d'une recherche documentaire où 20 documents sur 100 seraient pertinents :

- un classificateur qui trouverait correctement les 20 documents pertinents aurait une précision et un rappel de 1, donc

- un classificateur qui trouverait 30 documents, dont 15 pertinents, aurait une précision de 15 / 30 = 0.5 et un rappel de 15 / 20 = 0.75, donc

- un classificateur qui trouverait 80 documents, dont 15 pertinents, aurait une précision de 15 / 80 = 0.1875 et un rappel de 15 / 20 = 0.75, donc

Utilisation

La F-mesure a été basée sur les recherches de C. J. van Rijsbergen publiées en 1979 pour mesurer la pertinence de documents retournées par une requête en recherche d'information[4]. Elle est depuis très largement employée pour évaluer et comparer les performances de plusieurs classificateurs sur un même jeu de données, en permettant de s'assurer que les classificateurs ont des performances raisonnables aussi bien en termes de précision que de rappel, sans sacrifier l'une ou l'autre[3]. La F-mesure est appropriée même sur des données déséquilibrées où une classe est plus fréquente que l'autre, ce qui la rend plus utile dans ces cas que le taux de bonnes prédictions (accuracy)[3].

La F-mesure peut aussi servir de mesure d'utilité pour l'apprentissage de classificateur, où le but est de maximiser la F-mesure sur un jeu de données[5],[6],[7].

Limitations

La F-mesure ne peut pas directement être utilisée pour comparer des classificateurs entraînées sur des jeux de données différents où la répartition des classes diffèrent, car elle dépend de la distribution des classes[8].

Elle suppose, dans le cas binaire, qu'une des deux classes soit la plus désirable pour être la cible du calcul des taux de VP et FN[2]. Plus important, elle ne tient pas compte du taux de vrais négatifs (car ni la précision, ni le rappel ne l'utilise), ce qui rend la F-mesure inadaptée aux problèmes de classification où les vrais négatifs seraient importants (par exemple le diagnostic médical)[7].

Le choix de combiner la précision et le rappel réduit l'interprétabilité de la mesure, car précision et rappel portent sur des aspects différents de la performance et la F-mesure peut rendre plus difficile d'identifier les causes d'un manque de performance[9]. Notamment, différentes paires de précisions et rappels peuvent donner le même F-score. De plus, le choix de faire la moyenne harmonique entre la précision et le rappel est une approche conservatrice à laquelle pourrait se substituer la moyenne arithmétique[9].

Quand elle est utilisée pour optimiser un classificateur en phase d'apprentissage, la F-mesure pose difficulté car il n'existe pas d'expression de forme fermée permettant un calcul direct, et il faut donc recourir à des algorithmes d'optimisation en temps polynomiaux (

Implantation

La F-mesure est implantée dans plusieurs librairies d'apprentissage automatique et de statistiques pouvant construire des classificateurs, comme Scikit-learn[10], TensorFlow[11], PyTorch[12], R[13].